Một sản phẩm của BEACON MEDIA

Khám phá nhiều hơn với tài khoản

Đăng nhập để lưu trữ và dễ dàng truy cập những bài viết bạn yêu thích trên Bloomberg Businessweek Việt Nam.

"Effective altruism" (Chủ nghĩa nhân đạo có hiệu quả) là khái niệm được làm cho nổi tiếng bởi Sam Bankman-Fried, nhưng đằng sau nó là bức tranh lớn hơn về những sai lầm trong tư duy, cách gọi vốn, và cả sự cuồng tín của giới công nghệ.

Ảnh: Sophi Gullbrants cho Bloomberg Businessweek

Tác giả: Ellen Huet

24 tháng 03, 2023 lúc 10:00 AM

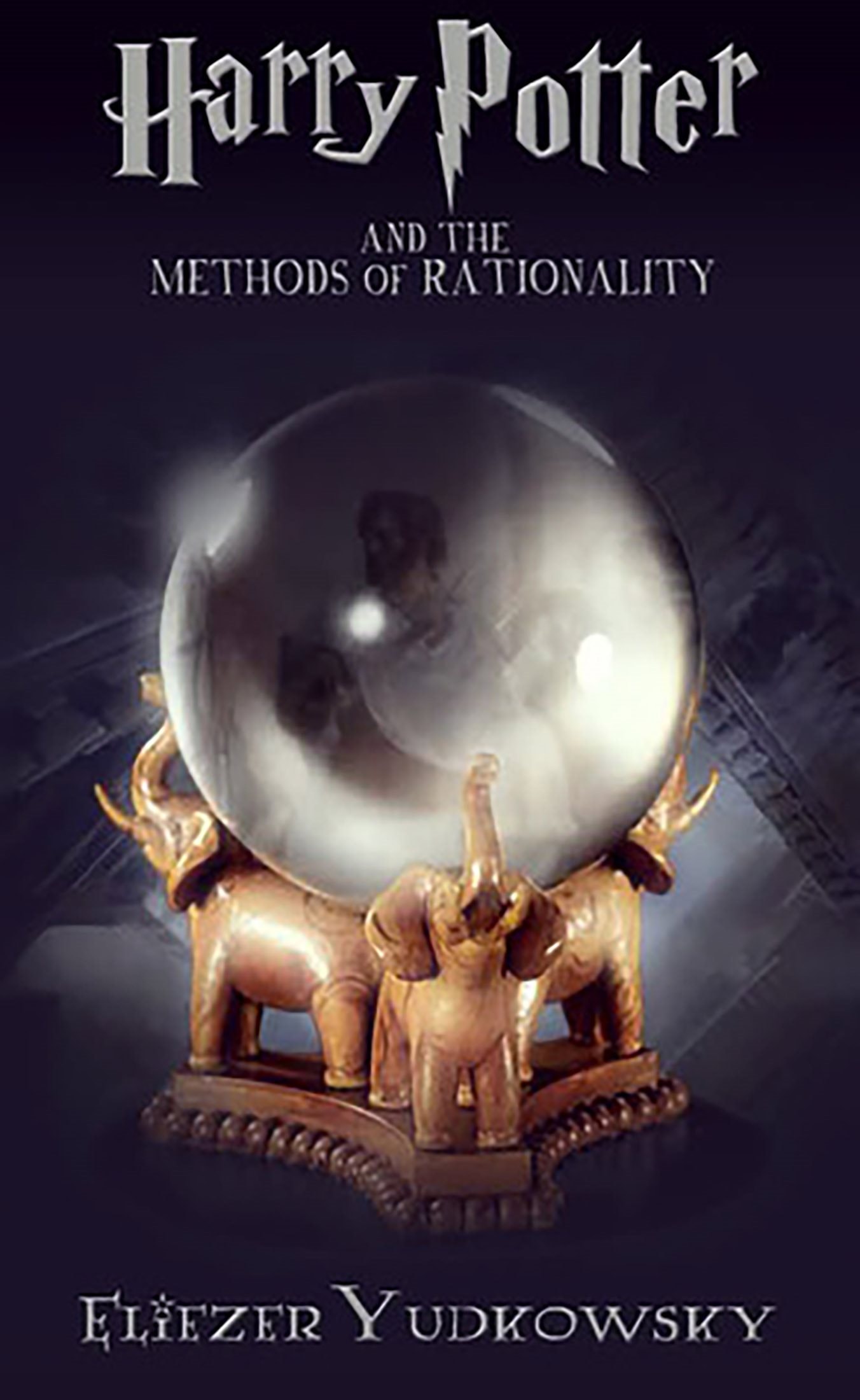

Sonia Joseph chỉ mới 14 tuổi khi cô lần đầu đọc truyện Harry Potter and the Methods of Rationality (Harry Porter và phương pháp duy lý), cuốn sách ăn khách do một người hâm mộ bộ truyện về chú bé phù thủy sáng tác. Chỉ có điều ở đây cậu bé là một nhà thực chứng khắc kỷ.

Theo đó, nhân vật Potter đầy duy lý này thử nghiệm các câu thần chú và phép thuật của giới phù thủy bằng những phương pháp khoa học, bác bỏ mọi điều không nhất quán, và giải quyết mọi vấn đề của thế giới phù thủy trước tuổi 12.

“Tôi cực thích cuốn sách đó,” Joseph, người đã đọc cuốn sách này bốn lần khi còn tuổi thiếu niên, chia sẻ. Cô là người Mỹ da đỏ lập dị, đầy tham vọng, thấy mình lạc lõng ở trường cấp ba ngoại ô Massachusetts. Câu chuyện đấy, theo lời cô, “rất hấp dẫn với những kẻ lập dị thông minh."

Sau đó, cuộc tìm kiếm các tác phẩm khác của cùng tác giả, Eliezer Yudkowsky, mở ra thêm nhiều cánh cửa cho Joseph. Từ đầu những năm 2000, Yudkowsky đã lập luận rằng trí tuệ nhân tạo hiếu chiến có thể hủy diệt nhân loại trong vòng vài thập kỷ. Lòng tin này thúc đẩy ông trở thành cha đỡ đầu trí tuệ cho một cộng đồng tự nhận là những người duy lý muốn tư duy của họ không bị thiên lệch, ngay cả khi những kết luận rút ra thật đáng sợ.

Mối quan tâm vừa chớm nở của Joseph với chủ nghĩa duy lý khiến cô bị cuốn hút theo chủ nghĩa nhân đạo có hiệu quả (Effective altruism), triết lý đạo đức đã mang tiếng xấu khắp nơi vì gắn liền với tay cựu tỉ phú tiền ảo thất sủng Sam Bankman-Fried.

Cốt lõi của chủ nghĩa này nhấn mạnh tư duy duy lý nhằm tạo ra tác động tích cực với hiệu quả tối đa lên thế giới. Những nhóm này (tuy khác biệt nhưng có mức độ liên quan nhất định với nhau) đã phát triển trên khắp các diễn đàn trực tuyến, nơi đăng tải những bài viết nói về nguy cơ của trí tuệ nhân tạo (AI).

Nhưng họ cũng sống tập trung ở vùng Bay Area, quanh vịnh San Francisco phía bắc tiểu bang California, nơi họ bắt đầu phác thảo lĩnh vực nghiên cứu mới - an toàn AI, nỗ lực ngăn cản các cỗ máy không tàn sát tất cả chúng ta.

Joseph chuyển tới vùng Bay Area làm công việc nghiên cứu AI không lâu sau khi tốt nghiệp cử nhân khoa học thần kinh năm 2019. Ở đó, cô nhận ra bối cảnh xã hội có vẻ lỏng lẻo trên mạng lại cực kỳ gắn bó ngoài đời thực. Nhiều người theo thuyết duy lý và chủ nghĩa nhân đạo có hiệu quả, tự gọi mình là các EA, hợp tác với nhau, đầu tư vào công ty của nhau, sống trong những căn nhà cộng đồng và chủ yếu tụ tập với nhau, đôi khi thành cả một mạng lưới quan hệ yêu đương lẫn lộn.

Giữa cộng đồng đấy, gần như tất cả đều thích thú được trở nên khác biệt, theo một nghĩa nào đấy. Joseph cảm thấy như được giải phóng và rất háo hức, như được giao du với những học trò trường phù thủy Hogwart theo phái duy lý ngoài đời thực. Cô cùng bè bạn đang xử lý những vấn đề mà cô thấy lý thú nhất, với mục tiêu khá lớn lao là cứu con người khỏi tuyệt chủng.

Đồng thời, cô bắt đầu quen với những lý lẽ lạ lùng. Một người đàn ông theo thuyết duy lý giới thiệu cô là “mồi nhử duy lý hoàn hảo” với một người khác. Cô bắt đầu nghe kể về hành vi tình dục sai trái của các nam lãnh đạo phong trào này, nhưng khi cô hỏi bạn bè, thì họ cho rằng những cáo buộc đó chỉ là sai sót nhỏ về tính cách không quan trọng so với mối đe dọa tận thế của AI.

Dần dần, cô bắt đầu hẹn hò với một nhà nghiên cứu AI trong cộng đồng. Cô cáo buộc anh ta đã có hành vi tình dục sai trái với cô, và đã báo cảnh sát San Francisco (Giống như nhiều phụ nữ ở vào hoàn cảnh tương tự, cô yêu cầu không nêu tên người đàn ông do sợ bị trả thù). Cáo buộc của cô khiến cộng đồng chia rẽ, theo lời cô, và mọi người nghi ngờ tình trạng tâm thần của cô, để bác bỏ những gì cô nói. Rốt cuộc cô chuyển sang Canada, nơi cô tiếp tục làm công việc AI và cố gắng xây dựng môi trường nghiên cứu lành mạnh hơn.

“Trong một thế giới lý tưởng, cộng đồng này sẽ thảo luận nghiêm túc về chính sách và giáo dục liên quan đến xâm hại tình dục: ‘Điểm mù của chúng ta là gì? Vì sao chuyện này lại xảy ra? Làm sao để chúng ta thiết kế các cơ chế ngăn chặn chuyện này xảy ra?’ ” cô nói. “Tôi cảm thấy thất vọng do cách cộng đồng nhìn nhận tôi qua lăng kính bị bóp méo, coi thường phụ nữ.”

Ở Thung lũng Silicon, những điểm chung giữa trào lưu duy lý, EA, và nghiên cứu an toàn AI tạo thành một tiểu khối văn hóa có ảnh hưởng sâu sắc. Trong khi ranh giới của các lĩnh vực đó không rõ ràng, hàng trăm hay hàng ngàn thành viên thống nhất bởi lòng tin rằng họ cần nỗ lực hết sức, hay ít ra là đầu tư rất nhiều tiền, để ngăn AI không trở thành kẻ hủy diệt loài người. Những người lãnh đạo phong trào được một số nhân vật giàu có và quyền lực nhất trong giới công nghệ ủng hộ, như Elon Musk, Peter Thiel và người tạo ra Ethereum Vitalik Buterin.

Và những ý tưởng của phong trào đã thu hút cả những người tin tưởng thật sự bình thường ở Thung lũng Silicon lẫn những kẻ cơ hội trơ trẽn. Cho tới gần đây, người ủng hộ hào phóng nhất cho phong trào là Bankman-Fried. Anh đầu tư gần 600 triệu đô la vào các sứ mệnh có liên quan trước khi chỉ trích chủ nghĩa nhân đạo có hiệu quả "chỉ là trò bịp" khi sàn FTX của anh sụp đổ.

FTX của Bankman-Fried bị sụp đổ khiến cộng đồng đấy bị nhìn nhận khắt khe hơn, nhưng anh không phải kẻ xấu duy nhất. Tính biệt lập và hướng tới mục đích chung khiến cộng đồng tiểu văn hóa đấy là chốn hấp dẫn cho cả những kẻ lập dị thông minh lẫn những kẻ lừa đảo, xâm hại tình dục và vĩ cuồng.

Lọc được mong muốn chính đáng làm sao để AI tốt hơn và an toàn hơn qua cặp mắt muốn phá vỡ mọi thứ quen thuộc của những nhà tiên tri Thung lũng Silicon luôn đi kèm rủi ro khiến cả dự án bị vấy bẩn.

Ý tưởng cơ bản của nó vốn đã cực đoan: sự thực duy lý đứng trên tất cả, đóng góp nhiều tiền nhất và làm nhiều điều tốt đẹp nhất cho lý do quan trọng nhất. Lối tư duy này có thể rất hấp dẫn nhờ sự rõ ràng của nó, nhưng nó cũng có thể là bình phong cho hành vi lừa gạt hay phá hoại. Tám phụ nữ trong cộng đồng tố cáo hành vi tình dục sai trái rộng khắp, bao gồm bạo lực và quấy rối, mà họ nói là thường xuyên không được chú ý. Thậm chí ngay nơi những người có ý định trong sáng, theo lời những thành viên cộng đồng, các lý tưởng EA và duy lý có thể khuếch đại nỗi đau của những người hay suy nghĩ về tận thế - khiến một số người có thể bị đổ vỡ về mặt tâm lý.

Những rạn nứt này để lại hệ quả trên phạm vi toàn cầu. Mối quan hệ và nguồn lực của cộng đồng khiến các thành viên có ảnh hưởng khác thường với sự phát triển AI, mục tiêu số một của ngành công nghệ ngày nay và là công cụ hùng mạnh khó tin trị giá nhiều tỉ đô la.

Những người tin tưởng đang cố gắng biến AI thành một thế lực làm điều thiện, nhưng các thành viên bi quan nói cộng đồng đầy tình ái hữu của họ đang bị lợi dụng và các kẻ không hề biết đến tinh thần nhân bản lạm dụng. “Thậm chí có khả năng cao là những hệ quả AI xấu sẽ xảy đến,” Joseph nói, “dùng đó làm lời biện minh để xâm hại nhân quyền là sự khinh khi mọi thứ mà chúng tôi đang đấu tranh cho.”

Khó xác định ranh giới trong bất kỳ cộng đồng nào có đạo đức cao xa kiểu này. Một số người theo thuyết duy lý không coi họ là người theo chủ nghĩa nhân đạo hiệu quả và ngược lại. Nhiều người thực ra đã bắt đầu tránh không để lòng tin của họ nghe có vẻ quá chính thống bằng những từ mới như “hậu duy lý” hay “cận EA.” Nhưng vẫn có hai điều rõ ràng: Trong thập kỷ qua, EA đã trở thành chủ lưu, thành khuôn mặt với công chúng của một số ý tưởng duy lý bên lề, nhất là nhu cầu khẩn thiết phải đảm bảo an toàn AI; và tất cả bắt đầu với Yudkowsky.

Sinh ra tại Chicago năm 1979, Yudkowsky bỏ đạo Do thái Chính thống hiện đại khi còn nhỏ, trở thành người vô thần. Ông không học hết cấp ba, nhưng khi còn thiếu niên đã ám ảnh với ý tưởng hợp thể, tức thời điểm mà tiến bộ công nghệ không thể tránh khỏi sẽ dẫn tới trí tuệ siêu nhân.

Ông bắt đầu viết về AI đầy háo hức từ những năm 2000, một thời gian dài sau khi các nhân vật phim viễn tưởng HAL 9000, Skynet và phim Matrix đã ăn sâu vào ký ức tập thể, nhưng ông đặc biệt viết rất nhiều. Suốt nhiều năm gần như ngày nào cũng có bài đăng blog, ông lập luận rằng giới nghiên cứu phải nỗ lực hết sức để đảm bảo rằng AI “đồng quy” với những giá trị con người. Vì mục đích này, ông lập ra viện Nghiên cứu Trí tuệ máy (MIRI) ở Berkeley, California, với nguồn tài trợ ban đầu từ Thiel và Jaan Tallinn, đồng sáng lập Skype.

Những ý tưởng của Yudkowsky ban đầu không thu hút được nhiều người tin tưởng. Nhưng ông có một món quà cho hoạt động marketing. Năm 2009, ông lập diễn đàn trực tuyến LessWrong, nơi dần trở thành trung tâm tranh luận của những người duy lý và thí nghiệm tư duy về AI. Tới năm 2010, Yudkowsky đăng tác phẩm HPMOR trên trang fanfiction.net.

Nhiều chương trong cuốn truyện dài kỳ chỉ dẫn người đọc tới các bài đăng trên LessWrong về những tín điều của người duy lý, và một số bài xin tài trợ cho trung tâm Duy lý ứng dụng (CFAR), một viện gắn với Yudkowsky ở Berkeley. HPMOR “là công cụ chiêu mộ cực kỳ hiệu quả những kẻ lập dị, những người mộng tưởng và những người tìm kiếm một cộng đồng,” Jacqueline Bryk, cũng là một tác giả và tự cho mình thuộc về cả ba nhóm đó, nói.

Đồng thời, chủ nghĩa nhân đạo có hiệu quả cũng phát triển song song. Nó khởi đầu với triết gia Peter Singer, người lập luận rằng những người có thể cứu được sinh mạng người khác phải cố gắng cứu được càng nhiều sinh mạng càng tốt. Nói ngắn gọn, thay vì đổ tiền quyên góp cho nhà hát opera, hãy bỏ tiền đấy mua màn chống muỗi gây bệnh sốt xuất huyết. Tới đầu những năm 2010, các tổ chức EA có tên đại loại như GiveWell vận động cho lựa chọn từ thiện dựa trên nghiên cứu, định lượng được. Nhiều EA cũng trở thành người ăn chay và nghiên cứu những cách thức chi phí thấp nhất nhằm giảm tổn thương cho động vật. Ở cốt lõi, phong trào duy lý và chủ nghĩa nhân đạo có hiệu quả có chung niềm tin là toán học sẽ giúp trả lời những câu hỏi hóc búa nhất. Năm 2013, Thiel, lúc đó vẫn chưa tham gia phong trào duy lý, có bài phát biểu chính ở một hội nghị toàn thể hàng năm của giới EA tổ chức trong một tòa nhà của những người duy lý tại khu vực Bay Area.

Tới năm 2014, ngày càng có nhiều người tin tưởng vào ngày tận thế do người máy gây ra. Nick Bostrom, triết gia đã biết Yudkowsky từ những năm 1990, xuất bản Superintelligence [Siêu trí tuệ], một cuốn sách bán chạy so sánh con người với đám trẻ nhỏ đang chơi một quả bom.

“Chúng ta không hề hay biết khi nào vụ nổ xảy ra, dù nếu đưa thiết bị đấy lên tai, chúng ta có thể nghe được tiếng tíc tắc mơ hồ,” ông viết. Stephen Hawking, Bill Gates và Elon Musk đều lên tiếng cảnh báo tương tự. “Với trí tuệ nhân tạo, chúng ta đang triệu hồi quỷ dữ,” Musk nói trong một hội thảo của viện Công nghệ Massachusetts năm 2014. Một năm sau, ông đồng sáng lập OpenAI, tổ chức phi lợi nhuận với tuyên ngôn mục tiêu giúp AI an toàn với con người. Một nhóm 80 nhà khoa học, học giả, và chuyên gia hàng đầu tập hợp trong một buổi hội thảo kín ở Puerto Rico để thảo luận về những rủi ro, rồi ký vào lá thư cảnh báo công khai.

Dần dần, thế giới của những người duy lý, EA, và nhà nghiên cứu an toàn AI bắt đầu hòa lẫn vào nhau. Những người EA nghĩ ra từ “chủ nghĩa dài hạn,” có nghĩa là nếu mọi mạng sống đều giá trị như nhau, thì tốt hơn là phải cứu được hàng ngàn tỉ mạng sống tương lai thay vì hàng tỉ sinh mạng trên hành tinh hiện giờ. Nên đã tới lúc dẹp màn chống muỗi và tập trung vào thảm họa diệt vong, như phổ biến vũ khí hạt nhân, các đại dịch tương lai, và tất nhiên, AI.

Trong vòng vài năm, ý tưởng đấy trở thành đề tài tranh luận rộng rãi ở Thung lũng Silicon. Trong các nhóm tiểu văn hóa liên quan, chủ nghĩa nhân đạo có hiệu quả cho tới giờ đóng vai trò chủ lưu nhất và có nhiều nhà tài trợ tỉ phú nhất, nên dịch chuyển theo hướng đó có nghĩa là kiếm được tiền thật và được chấp nhận.

Năm 2016, Holden Karnofsky, bấy giờ là đồng giám đốc điều hành Open Philanthropy, một tổ chức EA phi lợi nhuận được tài trợ của người đồng sáng lập Facebook Dustin Moskovitz, viết một bài trên blog giải thích quyết tâm mới của ông muốn ngăn chặn ngày tận thế AI. Những năm sau, tiền quyên tặng của Open Philanthropy cho các sứ mệnh kiểu chủ nghĩa dài hạn tăng từ hai triệu đô la Mỹ vào năm 2015 lên hơn 100 triệu đô la vào năm 2021.

Open Philanthropy đã trao 7,7 triệu đô la cho MIRI năm 2019, và Buterin tặng năm triệu đô la tiền mặt và tiền số. Nhưng những nhà tài trợ cá nhân khác nhanh chóng trở nên lép vế so với Bankman-Fried, một người EA lâu năm đã lập nên sàn giao dịch tiền số FTX và trở thành tỉ phú năm 2021. Trước khi khối tài sản của Bankman-Fried tan biến năm ngoái, anh đã tập hợp một nhóm các EA hàng đầu để điều hành quỹ vì mục đích dài hạn trị giá 100 triệu đô la mỗi năm của anh, Future Fund. Ở các văn phòng của quỹ này ở Berkeley, theo báo New Yorker, chủ đề chuyện phiếm là những câu hỏi về việc AI làm chủ con người sẽ diễn ra khi nào và khả năng là ra sao - hay theo cách nói trong riêng nhóm, “Thời gian biểu của anh là thế nào?” và “Tận thế với anh là gì?”

Chủ nghĩa nhân đạo có hiệu quả đang nghiêng về hướng an toàn AI. “Áp lực hiện là vậy,” một cựu thành viên cộng đồng giấu tên nói. “Nếu bạn đủ thông minh hay đủ giỏi về định lượng, dù có làm gì bạn cũng bỏ hết để chuyển sang làm về an toàn AI.” 80.0000 Hours (80 ngàn giờ), chương trình truyền thanh trực tuyến nhiều khán giả chuyên về lời khuyên sự nghiệp trong giới theo chủ nghĩa nhân đạo có hiệu quả, đã bắt đầu khuyến nghị những công việc trong lĩnh vực này, hơn bất kỳ lĩnh vực nào khác.

Nhưng cộng đồng đấy cũng bắt đầu chia rẽ. OpenAI, vốn là một tổ chức phi lợi nhuận khi ra mắt, vào năm 2019 nói họ sẽ chuyển đổi thành doanh nghiệp vì lợi nhuận với khoản đầu tư một tỉ đô la từ Microsoft. Hai năm sau, một số giám đốc của OpenAI tách ra thành lập công ty nghiên cứu riêng, Anthropic. Họ nói OpenAI thực ra đang thúc đẩy cỗ máy AI tới chỗ không thể kiểm soát, nên Anthropic sẽ tiếp tục làm công việc đúng đắn. Bankman-Fried đã đầu từ 580 triệu đô la vào Anthropic đầu năm ngoái.

Nỗi lo sợ viễn cảnh tận thế do AI gây ra để lại trong suy nghĩ các nhà nghiên cứu AI một câu hỏi gợi lại dự án chế bom nguyên tử Manhattan. Khi nghiên cứu AI, họ có đang bảo vệ tương lai nhân loại? Hay bất chấp những ý đồ tốt đẹp nhất, họ đang làm tình hình tồi tệ hơn?

Khi chủ nghĩa nhân đạo có hiệu quả ngày càng phổ biến, những chỉ trích nhắm vào triết lý đó cũng nhiều lên - cụ thể là ý tưởng “kiếm tiền để cho đi,” vốn cho rằng những người như Bankman-Fried phải làm tất cả để kiếm thật nhiều tiền rồi cho đi. Để tích tụ được nhiều tỉ đô la, Bankman-Fried có thể đã lừa đảo khách hàng, và những người chỉ trích nói thất bại của anh cho thấy chủ nghĩa EA dễ tổn thương vì tầm nhìn thiển cận lấy mục đích biện minh cho các phương tiện một cách bất hợp pháp.

Tuy nhiên, trong chính những người EA, sự chỉ trích tinh vi hơn: họ cho rằng sống theo những logic cực đoan của lý tưởng là điều không thực tế và là công thức gây thảm họa.

Những người EA cực kỳ tập trung vào tối ưu hóa tác động, tới mức cách phổ biến để phản bác một ý tưởng là nói nó “dưới mức tối ưu.” Tuy nhiên, tối đa hóa điều thiện là một nguyên lý bản thân nó không thể hiệu quả. (“Không có lý do gì để ta ngừng lại ở việc chỉ làm điều thiện,” Bankman-Fried nói khi xuất hiện trong chương trình 80 ngàn giờ.)

Nếu đóng góp 10% thu nhập của bạn cho việc thiện là tốt, thì theo logic, đóng góp nhiều hơn còn tốt hơn. Nói tới mức cực đoan, thì thứ chủ nghĩa hoàn hảo đấy sẽ làm ta tê liệt. Một nhân vật EA hàng đầu, Julia Wise, mô tả màn đấu tranh trí não mà cô phải đối mặt mỗi lần cân nhắc chuyện mua kem, và biết khoản tiền cô chi ra có thể được dùng để chích vắc xin cho một ai đó ở nước ngoài.

Cũng vì những lý do đó, cô dằn vặt không biết có thể biện minh cho việc có con không; khi cha cô lo lắng vì cô có vẻ buồn bực, cô nói: “Vấn đề không phải là hạnh phúc của con.”

Đến nay thì Wise đã xem xét lại ngân sách mua kem và đã thành mẹ, nhưng nhiều người EA khác vẫn mắc kẹt trong “chiếc bẫy tâm trạng thảm hại” đấy. Một cựu EA viết trên Twitter rằng tiếng nói nội tâm của anh “sẽ tự động chuyển toàn bộ số tiền mà tôi đã tiêu xài (để ăn tối chẳng hạn) thành ‘số đếm những ca tử vong’ với những sinh mạng tương lai mà tôi lẽ ra cứu được nếu góp tiền đó cho từ thiện.”

Một người khác viết trên Twitter rằng “lý tưởng EA khiến người tuân theo tự coi họ như những cỗ máy với mục đích là phải hành động theo lý tưởng đó,” điều khiến họ “đè nèn những phần quan trọng trong nhân tính của mình.” Nói đỡ căng thẳng hơn thì người EA thường thấy khó mà vừa rảo bước vừa nhai kẹo cao su, vì động tác nhai khiến động tác đi bộ không còn tối ưu.

Ưu tiên của phong trào đấy với an toàn AI cũng gây nhiều ngờ vực trong giới chỉ trích, vốn thấy lối tiếp cận được ăn cả ngã về không này là một kiểu né tránh, để không phải can dự vào những vấn đề có thể giải quyết được, có lợi cho ngành công nghệ.

"Nếu bạn thực sự nghĩ AI ngầu, thì chẳng phải là sẽ tốt hơn nếu bạn tin mình phải nỗ lực làm việc với nó để cứu thế giới sao?” Timnit Gebru, nhà đạo đức học AI thường viết những tweet chê bai chua cay chủ nghĩa nhân đạo có hiệu quả, nói. “Bạn không cần phải thấy tội lỗi vì không giải quyết được nạn đói.”

Ngay cả những nhân vật EA hàng đầu cũng nghi ngờ việc chuyển hướng sang AI. Larissa Hesketh-Rowe, giám đốc hoạt động ở Leverage Research và cựu CEO Trung tâm nhân đạo có Hiệu quả, nói cô chưa bao giờ hiểu rõ tại sao có người lại nói được là họ đang giúp AI an toàn hơn.

Theo cô, khi những người có địa vị cao trong cộng đồng nói rủi ro AI là lĩnh vực nghiên cứu trọng yếu, những người khác đơn giản là vuốt đuôi theo. “Không ai nói thẳng, nhưng bạn sẽ có xu hướng bị lôi kéo đồng ý với những người mà nếu đồng ý với họ, bạn sẽ thuộc về nhóm ngầu,” cô nói.

“Nếu bạn không hiểu, có nghĩa là bạn không đủ thông minh, hay không đủ thiện lành.” Hesketh-Rowe, đã bỏ việc vào năm 2019, và đã vỡ mộng với EA, cũng cho rằng cộng đồng đấy đang trở nên quá bầy đàn.

Với những nhóm cực đoan trong cộng đồng duy lý, giới nghiên cứu AI tin rằng căng thẳng liên quan tới nỗi sợ tận thế của họ sẽ dẫn tới hoảng loạn thần kinh. Công việc của Jessica Taylor, nhân viên MIRI, là đôi khi phải “tưởng tượng ra những kịch bản AI kinh hoàng nhất,” như cô mô tả trong một bài đăng trên LessWrong - những đau khổ tồi tệ nhất mà AI có thể gây ra cho con người.

Cô kể khi làm việc, cô và một nhóm nhỏ những nhà nghiên cứu tin rằng “chúng ta có thể tạo ra Thượng đế, nhưng chúng ta có thể gây nên hỗn loạn và hủy diệt tất cả.” Năm 2017, cô phải nhập viện ba tuần vì ảo giác rằng mình “xấu xa từ trong xương tủy” và “đã hủy diệt nhiều vùng rộng lớn của thế giới bằng sức mạnh như ác quỷ của tôi,” cô viết trong một bài đăng.

Dù cô thừa nhận có sử dụng thuốc gây ảo giác vì lý do trị liệu, cô cũng nói ảo giác của cô là do lẫn lộn giữa các kịch bản ác mộng trong công việc với đời sống thật. “Ở một bệnh nhân bình thường, hoang tưởng mình là quỷ dữ được coi là chứng vĩ cuồng,” cô viết. “Còn ở đây ý tưởng này thật tự nhiên do môi trường xã hội thường nhật của tôi, và là trọng tâm khiến tôi suy sụp về tinh thần.”

Và không chỉ có mình Taylor. Trải nghiệm đó bao bọc tâm trạng văn hóa chung của một số người theo thuyết duy lý, thường là ở các nhân viên của MIRI hay CFAR, sống cùng nhau, và bị ám ảnh bởi nỗ lực thử thách giới hạn của các tiêu chuẩn xã hội, chân lý, và thậm chí là tư duy có nhận thức.

Họ gọi người ngoài cuộc là dân thường hay NPC, tức nhân vật không phải người chơi, nhân vật phụ trong các trò chơi điện tử do máy điều khiển, chỉ nói được vài câu và không có vai trò trong cốt truyện. Trong những cuộc tiệc tùng, họ sẽ “giải mã” lẫn nhau, tức nói chuyện vặn vẹo kiểu thẩm vấn, mà họ tin là sẽ dẫn tới nhiều suy nghĩ duy lý hơn.

Đôi khi, để đẩy lý luận đi xa, họ thí nghiệm thuốc gây ảo giác và tìm cách “phá vỡ ngục tù” tâm trí, nhằm mở toang ý thức và tạo ra ảnh hưởng lớn hơn, hay “tự kiểm soát.” Một số người quen biết Taylor cũng trải qua tình trạng tâm lý tương tự. Một người đã tự sát chết vào năm 2018, rồi một người nữa năm 2021.

Một số thành viên và cựu thành viên của cộng đồng này nói bầu không khí có thể trở nên “như một giáo phái.” Một số người trong cuộc gọi lòng cuồng tín với tận thế do AI này là một tôn giáo thế tục; một người từng theo thuyết duy lý nói đó là giáo hội của những người vô thần.

Nó tạo ra mục đích cao cả hơn mà người ta có thể dành cả đời cho, và một quyền lực hỏa ngục cũng cao hơn để sợ hãi. Trong nhóm, có cảm giác không nói ra rằng họ là những người được lựa chọn, đủ thông minh để nhìn thấy chân lý và cứu thế giới, những người “ý thức được vũ trụ,” theo lời Qiaochu Yuan, một người từng theo thuyết duy lý.

Yuan bắt đầu chơi với những người duy lý vào năm 2013, khi đang làm tiến sĩ toán ở Đại học California, Berkeley. Khi anh bắt đầu thấy thực sự tin ở ý tưởng AI có thể quét sạch con người trong 20 năm nữa, anh bỏ học, không tính toán chuyện nghỉ hưu nữa, và tránh xa bạn bè cũ, những người không từng giây từng phút lo lắng đảo ngược tận thế.

"Ta thực sự có thể thao túng mọi người làm đủ thứ chuyện điên khùng nếu thuyết phục được họ rằng đó là cách để giúp thế giới không chấm dứt,” anh nói. “Một khi đã rơi vào kiểu tư duy đó, nó sẽ thực sự bóp méo khả năng nhìn thấy bất kỳ gì khác.”

Tình trạng mất năng lực quan tâm này rõ ràng nhất khi nói tới cách đối xử với phụ nữ trong cộng đồng, khi những kẻ cơ hội lợi dụng lý luận tận thế để có hành động độc ác hay lạm dụng. Trong tiểu văn hóa của những người duy lý, EA và nghiên cứu an toàn AI, quấy rối và xâm hại tình dục phổ biến một cách đáng buồn, theo lời tám phụ nữ ở mọi cấp độ của cộng đồng. Nhiều phụ nữ trẻ, tham vọng mô tả một xu hướng quen thuộc: Ban đầu họ bị các ý tưởng lôi kéo, rồi chìm đắm trong khung cảnh xã hội đấy. Thường điều đó đồng nghĩa đến tham dự các buổi tiệc ở nhà các nhóm EA hay duy lý, hay được mời vào các nhóm chat Facebook Messenger chuyên dùng thuật ngữ cùng hàng trăm người cùng chí hướng.

Tám phụ nữ đấy nói tình trạng coi thường phụ nữ là rất phổ biến. Tệ nhất, Bryk, tác giả cận duy lý, nói một người duy lý nổi tiếng từng khinh khi gọi cô là “đứa trẻ 5 tuổi trong một cơ thể nóng bỏng 20 tuổi.” Quan hệ yêu đương với đàn ông lớn tuổi hơn nhiều là phổ biến, việc yêu nhiều người một lúc cũng vậy.

Những chuyện đó bản thân chúng không có hại, nhưng một số phụ nữ nói các tiêu chuẩn trở thành công cụ giúp người đàn ông lớn tuổi có ảnh hưởng có nhiều bạn tình hơn. Keerthana Gopalakrishnan, nhà nghiên cứu AI ở Google Anh quốc, năm nay gần 30 tuổi, đã dự các cuộc gặp gỡ EA nơi cô bị những người đàn ông đã có bạn đời tán tỉnh và lên lớp cho cô về chuyện hôn nhân một vợ một chồng đã là lỗi thời và đa phu đa thê mới là tiến hóa hơn.

“Nếu bạn là một phụ nữ tương đối hấp dẫn trong một cộng đồng EA, bạn sẽ nhận được vô số những đề nghị quan hệ tình dục với nhiều người, thường từ những người đàn ông yêu nhiều người hay đã có bạn đời,” những người này đôi khi có ảnh hưởng lớn và trực tiếp bỏ tiền cho phong trào, cô viết trên một diễn đàn EA kể lại trải nghiệm của mình. Bài đăng của cô nhận rất nhiều chê bai, và cô cuối cùng đã gỡ nó xuống.

Những giáo huấn dẫn đường của cộng đồng có thể được sử dụng để biện minh cho kiều hành động đấy. Nhiều người trong cộng đồng lập luận rằng duy lý dẫn tới những quyết định siêu việt về thế giới và khiến quy tắc đạo đức của đám NPC trở nên lỗi thời.

Sonia Joseph, người đã chuyển tới vùng Bay Area để theo đuổi sự nghiệp trong ngành AI, năm 22 tuổi được khuyến khích ăn tối với một người sáng lập công ty khởi nghiệp tầm 40 tuổi trong cộng đồng duy lý, vì anh ta có quan hệ gần gũi với Thiel.

Trong bữa tối, người đấy khoe khoang rằng Yudkowsky đã lấy anh ta làm hình mẫu cho một vị giáo sư là nhân vật quan trọng trong tác phẩm HPMOR. Joseph kể anh ta cho rằng chuyện trẻ em gái 12 tuổi có quan hệ tình dục với đàn ông trưởng thành là bình thường, và những mối quan hệ như vậy là cách thức cao cả để trao truyền kiến thức cho thế hệ trẻ hơn. Rồi cô kể anh ta theo cô về nhà và khăng khăng đòi ở lại. Cô nói anh ta ngủ trên sàn trong phòng khách nhà cô, và cô cảm thấy không an toàn khi anh ta rời đi vào sáng hôm sau.

Cực đoan nhất, năm phụ nữ, một số người xin giấu tên vì sợ trả thù, nói đàn ông trong cộng đồng tấn công tình dục hoặc có hành vi sai trái với họ. Họ nói sau đó họ thường phải đối phó với những phản ứng ngược cả ở sở làm cũng như về mặt cảm xúc và xã hội. Bối cảnh xã hội giao cắt sâu sắc với ngành AI ở vùng Bay Area, bao gồm những nhà sáng lập, giám đốc, nhà đầu tư và nghiên cứu.

Phụ nữ báo cáo các vụ xâm hại tình dục, với cảnh sát hoặc những người trung gian trong cộng đồng, nói họ bị coi là gây chuyện và bị tẩy chay trong khi đàn ông được bảo vệ.

Năm 2018, hai người cáo buộc Brent Dill, một người duy lý tình nguyện làm việc cho CFAR, xâm hại họ khi họ đang có quan hệ yêu đương với anh ta. Họ đều 19 tuổi, và anh ta khoảng gấp đôi tuổi họ. Cả hai nói anh ta dùng ma túy và thuốc kích thích cảm xúc để ép họ tham gia những cảnh bạo dâm kinh khủng mà họ thấy hoàn toàn khó chấp nhận.

Đáp lại cáo buộc, một ủy ban CFAR phát tán tóm tắt cuộc điều tra họ thực hiện với những cáo buộc trước đó nhắm vào Dill, về cơ bản là xóa tội cho anh ta. “Anh ấy gắn bó với những mục tiêu và chiến lược của CFAR và phải coi anh ấy là một đồng minh,” ủy ban viết, và gọi anh là “một nhân vật kết nối và thúc đẩy quan trọng của cộng đồng,” người “là hiện thân hiếm thấy của tinh thần trách nhiệm anh hùng.”

(Sau nhiều phản đối, CFAR xin lỗi vì phản ứng “hết sức không đầy đủ” của họ, giải tán ủy ban và cấm Dill tham gia các sự kiện của họ. Dill không trả lời yêu cầu bình luận của chúng tôi.)

Rochelle Shen, người sáng lập một công ty khởi nghiệp từng điều hành một trụ sở cho nhóm cận duy lý, cũng nghe thấy những biện minh tương tự từ một phụ nữ trong cộng đồng chuyên xử lý các cáo buộc hành vi tình dục sai trái. Người điều phối này liên tục yêu cầu Shen phải nghĩ tới những phản ứng ngược cho người đàn ông. “Cô chắc không muốn hủy hoại sự nghiệp của anh ta,” Shen kể người phụ nữ đã nói vậy.

“Cô nên nghĩ tới những hậu quả với cộng đồng.”

Một phụ nữ trong cộng đồng, xin được giấu tên vì sợ trả thù, nói cô từng bị một nhà nghiên cứu AI hàng đầu xâm hại. Cô kể sau khi sau khi cô đương đầu với anh ta, những lời mời cô làm việc, phát biểu tại hội thảo, và dự sự kiện AI đều bị rút lại. Cô nói những người khác trong cộng đồng cho rằng cáo buộc của cô gây hại cho bước tiến của an toàn AI, và một người còn cho rằng lựa chọn tối ưu là cô nên tự sát.

Với một số phụ nữ đưa ra cáo buộc về xâm hại trong cộng đồng, điều làm họ đau khổ nhất là bị vỡ mộng. Angela Pang, một phụ nữ 28 tuổi biết tới giới duy lý qua những bài đăng trên Quora, nhớ lại niềm vui của cô khi phát hiện ra một cộng đồng cũng suy nghĩ về thế giới giống cô. Cô đã thử nghiệm ăn chay để giảm đau khổ cho động vật, và nhanh chóng kết nối với những ý tưởng tối ưu hóa của chủ nghĩa nhân đạo có hiệu quả.

Cô nói cô đã bị một người trong cộng đồng tấn công tình dục, người này lúc đầu thừa nhận đã sai, nhưng sau đó lại phủ nhận. Lời phủ nhận khiến cô cảm thấy bị xâm hại hai lần. “Mọi người đều tin tôi, nhưng tin thôi là không đủ,” cô nói. “Ta cần những người hết sức quan tâm tới xâm hại tình dục.”

Pang lớn lên trong một gia đình nhiều bạo lực; cô kể cô từng chứng kiến một vụ bạo lực gia đình của gia đình mình ở một tiệm tạp hóa. Những người qua đường đứng lại nhìn, nhưng vẫn tiếp tục làm những gì họ đang làm. Cô cảm thấy những gì cô trải qua rất giống như vậy.

Những cáo buộc của các phụ nữ trong cộng đồng không hề khiến ý tưởng về an toàn AI kém đi tầm quan trọng. Chúng ta đều đã biết AI làm nhiệm vụ đơn lẻ hiện có thể bóp méo kết quả như thế nào, từ các thuật toán biện minh cho phân biệt chủng tộc tới phân chia tiền lương phân biệt giới tính.

Cả AI siêu thông minh cũng có xu hướng phản ánh những thiên lệch nơi người tạo ra nó, dù xấu dù tốt. Nhưng khả năng khiến AI an toàn hơn một chút không hề khiến an toàn của phụ nữ trở nên kém quan trọng hơn.

Hai mươi năm trước, những lo ngại của Yudkowsky về an toàn AI là chuyện bên lề. Ngày nay, họ có hàng tỉ đô la chống lưng và con số đang ngày càng tăng lên - Google đã đầu tư 400 triệu đô la vào Anthropic vào tháng 2 - nhưng những nỗ lực tập trung vào an toàn vẫn chỉ thu hút được một phần nhỏ tiền bạc trong ngành này, so với tiền bỏ ra cho cuộc đua vũ trang phát triển AI.

ChatGPT của OpenAI có thể vượt qua một kỳ thi trường luật; DALL-E cũng của họ có thể vẽ những chú cá voi hồng bay trong mây. Microsoft đang thử nghiệm AI trong công cụ tìm kiếm Bing. Dù quan điểm chung là AI thực sự có cảm xúc vẫn còn xa mới là hiện thực, tốc độ nghiên cứu đang được đẩy lên rất nhanh.

Cả những câu hỏi và tội lỗi ám ảnh phong trào duy lý đang ngày càng trở nên quan trọng. Yudkowsky giờ nhìn nhận những nỗ lực thương mại của OpenAI là con đường “gần như tồi tệ nhất có thể,” con đường sẽ đẩy nhanh tận thế của chúng ta. Trong một chương trình truyền thanh trực tuyến tháng trước, ông nói ông đã gần như hết hy vọng cứu vãn nhân loại. “Vấn đề là triệu hồi ác quỷ thì dễ, triệu hồi thiên thần lại khó hơn nhiều,” ông nói.

Năm 2003, cũng khoảng thời gian các phần sau của loạt phim Matrix ra rạp và kịch bản tận thế AI trở nên phổ biến trong những cuộc trò chuyện ở ký túc xá sinh viên ban đêm, Bostrom đề xuất một thí nghiệm tư duy về một con AI mà mục tiêu là làm ra số lượng kẹp giấy lớn nhất có thể. Con AI sẽ nhanh chóng nhận ra rằng để tối đa hóa mục tiêu đó, không thể tồn tại con người: Nếu con người quyết định tắt AI, thì điều đó sẽ ngăn không thể làm ra kẹp giấy nữa, và trong con người có những nguyên tử có thể sử dụng để làm ra kẹp giấy.

Ông kết luận rằng con AI sẽ có động cơ rất mạnh để tìm cách khai thác chúng ta và mọi thứ trên hành tinh để đạt mục tiêu của nó. Máy tối đa hóa kẹp giấy (The Paperclip Maximizer), tên nó là như vậy, là một meme tiềm năng về những lầm lạc của sự tin tưởng mù quáng vào máy móc.

(Chú thích của người dịch: The Paperclip Maximizer là một meme nói về giả định một trí tuệ nhân tạo được lập trình để làm ra "càng nhiều kẹp giấy" càng tốt, mà không quan tâm tới hệ quả của việc đó có thể hủy hoại cả hành tinh trái đất.)

Mọi nhà nghiên cứu an toàn AI hiểu rõ "The Paperclip Maximizer" là gì. Nhưng ít người hiểu được cách thức nền tiểu văn hóa duy lý bắt chước tầm nhìn hạn hẹp đó.

Khi AI trở nên ngày một hùng mạnh, được mất sẽ chỉ càng nhiều hơn với những ai bị ám ảnh bởi nhiệm vụ mà họ tự nhận, nhằm kiểm soát được AI. Những tổn thất ngoài dự kiến của quá trình đó không quan trọng. Họ sẽ chỉ nghĩ tới mục tiêu "kẹp giấy" duy nhất của họ: cứu lấy thế giới, bất chấp việc hủy hoại rất nhiều thứ khác.

Theo Bloomberg

Theo phattrienxanh.baotainguyenmoitruong.vn

https://phattrienxanh.baotainguyenmoitruong.vn/dang-sau-tri-tue-nhan-tao-la-mot-con-cuong-tin-cua-thung-lung-silicon-50277.html

Tặng bài viết

Đối với thành viên đã trả phí, bạn có 5 bài viết mỗi tháng để gửi tặng. Người nhận quà tặng có thể đọc bài viết đầy đủ miễn phí và không cần đăng ký gói sản phẩm.

Bạn còn 5 bài viết có thể tặng

Liên kết quà tặng có giá trị trong vòng 7 ngày.

BÀI LIÊN QUAN

Gói đăng ký

Truy cập nhanh

Giấy phép thiết lập trang thông tin điện tử tổng hợp trên mạng số 30/ GP-STTTT do Sở Thông Tin và Truyền Thông thành phố Hồ Chí Minh cấp ngày 24/12/2024

Chịu trách nhiệm nội dung: Ông Võ Quốc Khánh

Trụ sở: Lầu 12A, số 412 Nguyễn Thị Minh Khai, phường Bàn Cờ, Thành phố Hồ Chí Minh

Điện thoại: (028) 8889.0868

Email: bientap@bloombergbusinessweek.vn

© Copyright 2023-2025 Công ty Cổ phần Beacon Asia Media